在 LobeVidol中使用 Groq

Groq 的 LPU 推理引擎 在最新的独立大语言模型(LLM)基准测试中表现卓越,以其惊人的速度和效率重新定义了 AI 解决方案的标准。通过 LobeVidol与 Groq Cloud 的集成,你现在可以轻松地利用 Groq 的技术,在 LobeVidol中加速大语言模型的运行。

Groq 的 LPU 推理引擎 在最新的独立大语言模型(LLM)基准测试中表现卓越,以其惊人的速度和效率重新定义了 AI 解决方案的标准。通过 LobeVidol与 Groq Cloud 的集成,你现在可以轻松地利用 Groq 的技术,在 LobeVidol中加速大语言模型的运行。

Groq LPU 推理引擎在内部基准测试中连续达到每秒 300 个令牌的速度,据 ArtificialAnalysis.ai

的基准测试确认,Groq 在吞吐量(每秒 241 个令牌)和接收 100 个输出令牌的总时间(0.8

秒)方面优于其他提供商。

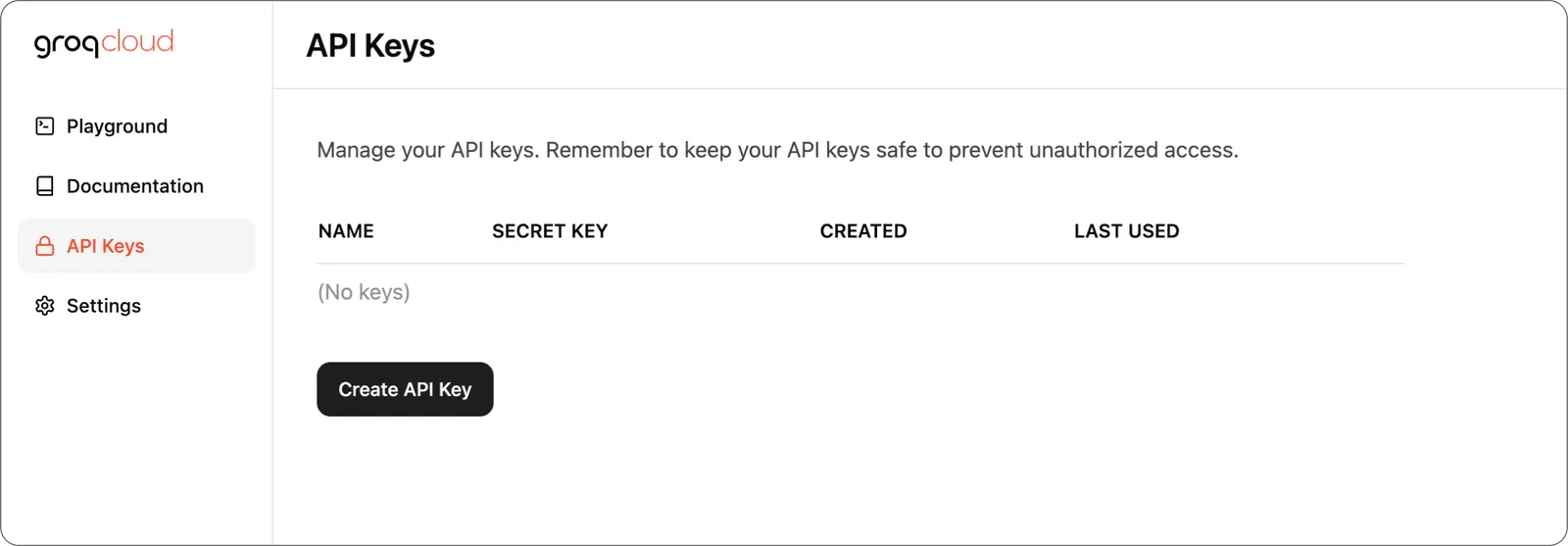

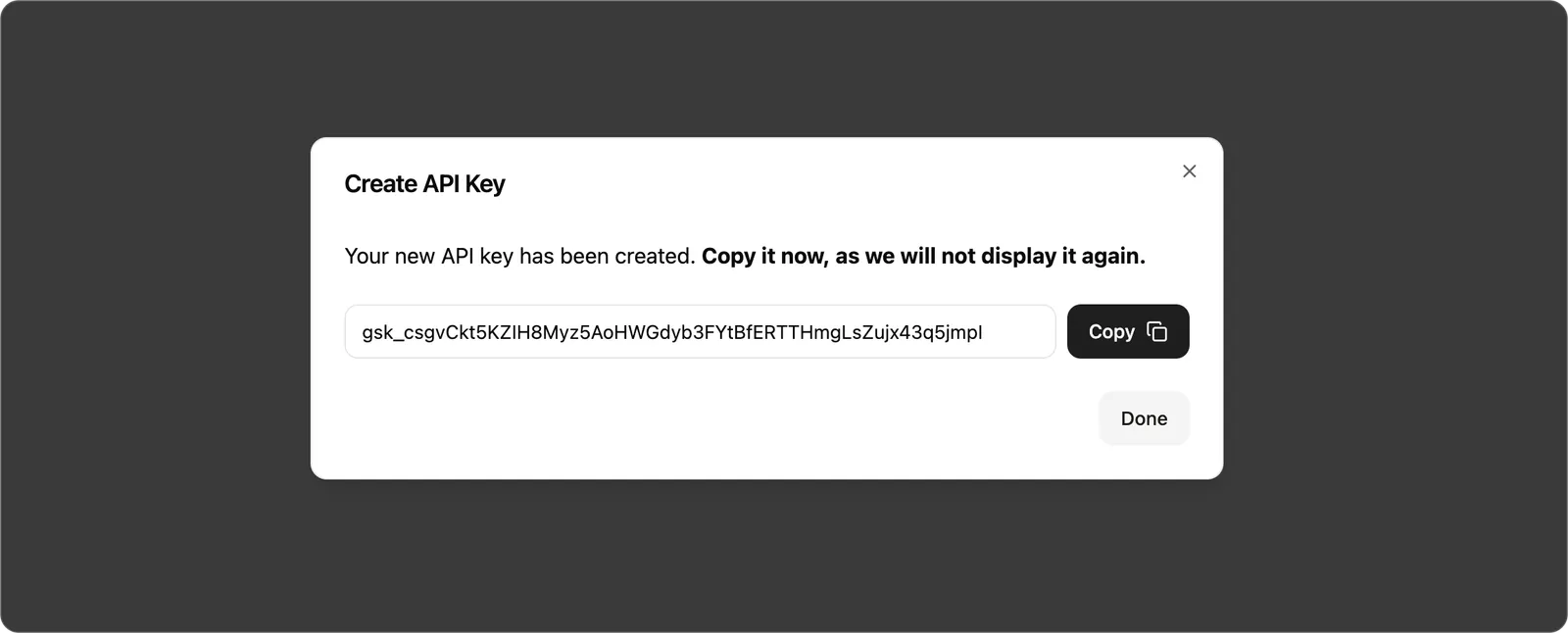

步骤 1: 获取 GroqCloud API Key

首先,你需要到 GroqCloud Console 中获取一个 API Key。 在控制台的

在控制台的 API Keys 菜单中创建一个 API Key。

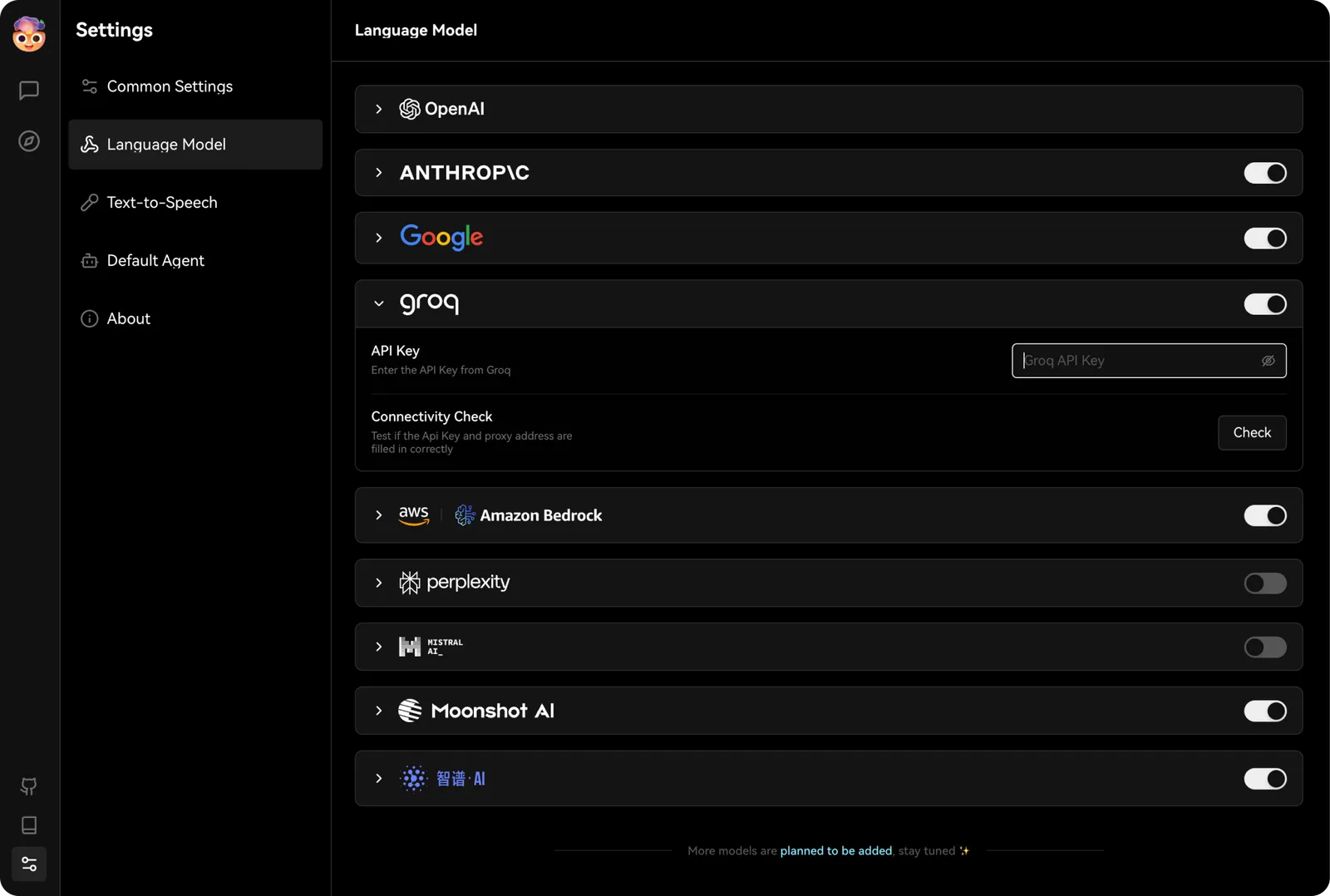

步骤 2: 在 LobeVidol中配置 Groq

你可以在设置 -> 语言模型 中找到 Groq 的配置选项,将刚才获取的 API Key 填入。

接下来,在助手的模型选项中,选中一个 Groq 支持的模型,就可以在 LobeVidol中体验 Groq 强大的性能了。

接下来,在助手的模型选项中,选中一个 Groq 支持的模型,就可以在 LobeVidol中体验 Groq 强大的性能了。